[Debian/Ubuntu] 本地部署Deepseek-R1

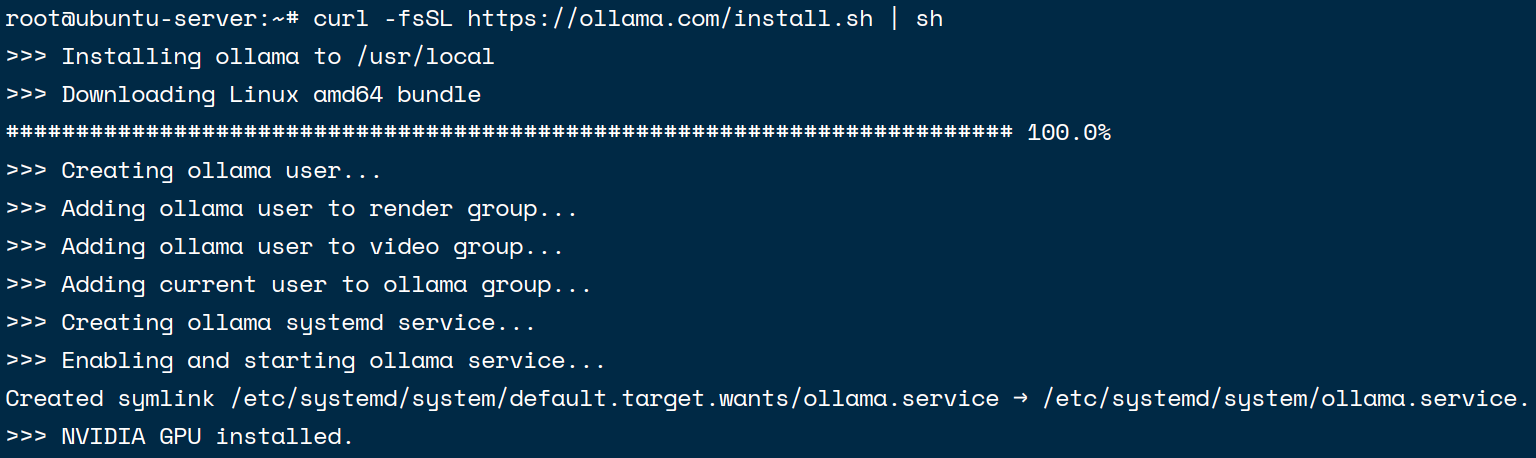

1. 安装 ollama

Linux的话官网有安装脚本, 直接sudo/root执行就可以了. 官网链接

curl -fsSL https://ollama.com/install.sh | sh

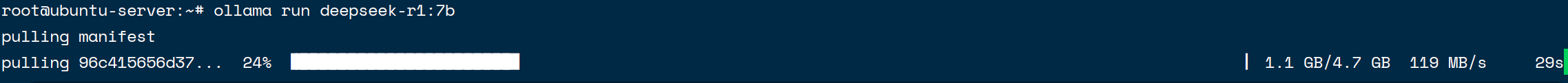

2. 部署 Deepseek

打开Models, 点进Models里, 找到Deepseek-R1

这里演示的电脑只有4060, 显存8GB, 所以我们选择部署7b的模型

ollama run deepseek-r1:7bollama会自动下载模型

下载完成后就可以自动开始对话了

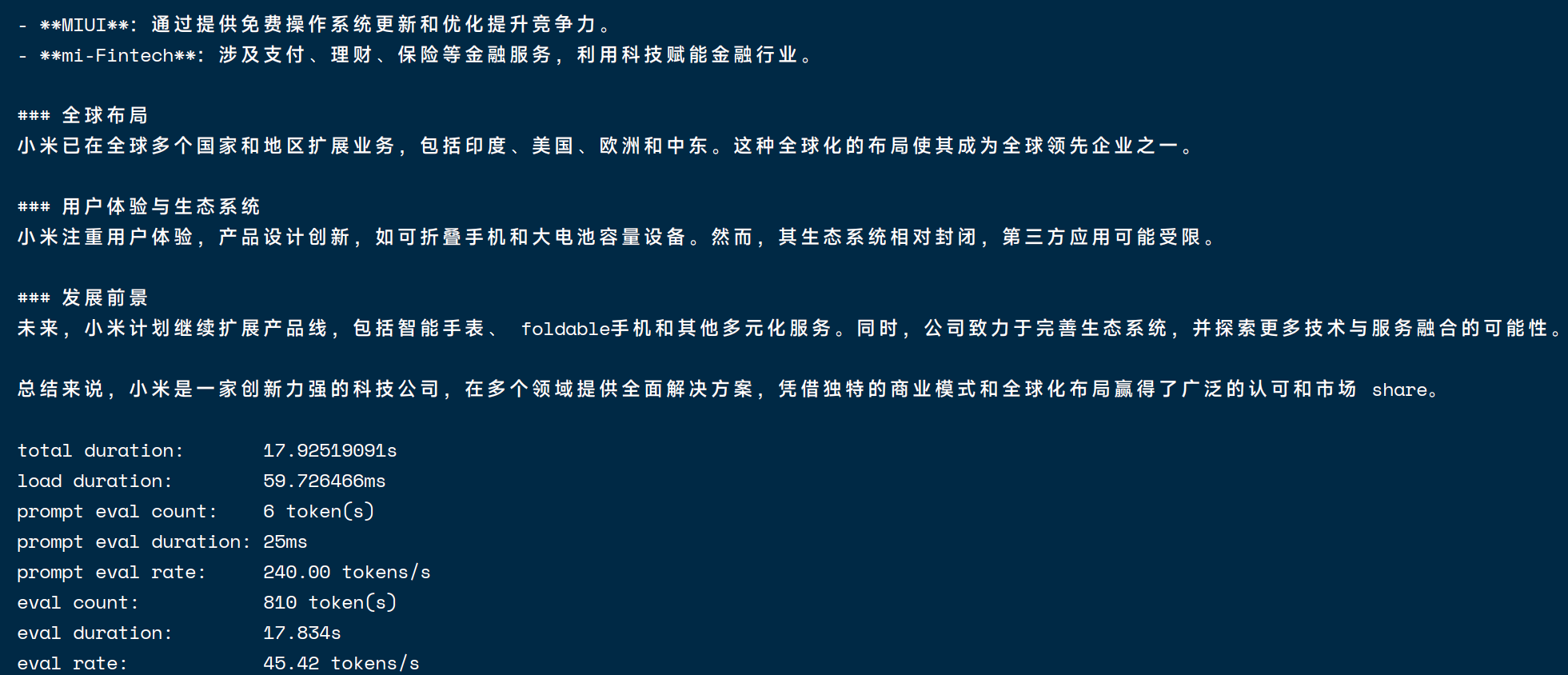

3. 显示性能参数

加上--verbose就可以了, 比如我这里

ollama run deepseek-r1:7b --verbose如下

root@ubuntu-server:~# ollama run deepseek-r1:7b --verbose

>>> 你好

<think>

</think>

你好!很高兴见到你,有什么我可以帮忙的吗?

total duration: 809.681259ms

load duration: 58.249772ms

prompt eval count: 4 token(s)

prompt eval duration: 374ms

prompt eval rate: 10.70 tokens/s

eval count: 17 token(s)

eval duration: 374ms

eval rate: 45.45 tokens/s如果要测试固定的语句, 则是

ollama run deepseek-r1:7b "介绍一下小米公司" --verbose如图

查看一下吃了多少显存

root@ubuntu-server:~# nvidia-smi

Wed Feb 19 13:46:52 2025

+-----------------------------------------------------------------------------------------+

| NVIDIA-SMI 565.57.01 Driver Version: 565.57.01 CUDA Version: 12.7 |

|-----------------------------------------+------------------------+----------------------+

| GPU Name Persistence-M | Bus-Id Disp.A | Volatile Uncorr. ECC |

| Fan Temp Perf Pwr:Usage/Cap | Memory-Usage | GPU-Util Compute M. |

| | | MIG M. |

|=========================================+========================+======================|

| 0 NVIDIA GeForce RTX 4060 Off | 00000000:06:10.0 Off | N/A |

| 0% 40C P8 N/A / 115W | 5241MiB / 8188MiB | 0% Default |

| | | N/A |

+-----------------------------------------+------------------------+----------------------+

+-----------------------------------------------------------------------------------------+

| Processes: |

| GPU GI CI PID Type Process name GPU Memory |

| ID ID Usage |

|=========================================================================================|

| 0 N/A N/A 161113 C /usr/local/bin/ollama 5232MiB |

+-----------------------------------------------------------------------------------------+可以看到只能部署7b, 14b大约需要10GB显存就不够了

[Debian/Ubuntu] 本地部署Deepseek-R1

https://blog.onanii0721.website//archives/linuxdeepseekr1